«Если научить модель распознавать тексты, написанные от руки, она сможет лучше решать математические примеры. Пока нет разумной теории, почему и как это происходит», — говорит один из главных экспертов по ИИ в стране, генеральный директор Института AIRI Иван Оселедец. Среди его задач — сильный искусственный интеллект и бытовые роботы, которые могут пойти и сделать вам яичницу или собрать мусор, причем и то и другое может появиться уже через несколько лет. В интервью «БИЗНЕС Online» ученый рассказал о месте России в гонке ИИ, борьбе разработчиков с цензорами, попытках регулирования и выращивании кадров в условиях, когда у бизнеса к вузам нет доверия.

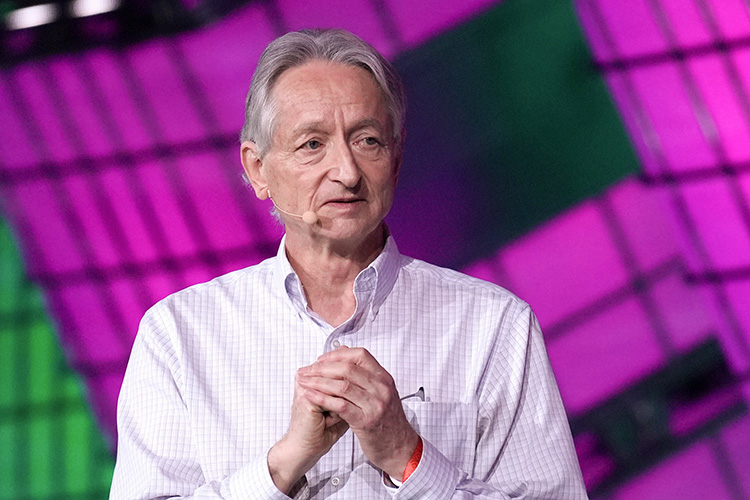

Иван Оселедец: «У нас очень простая, но амбициозная цель — это развитие методов сильного искусственного интеллекта»

Иван Оселедец: «У нас очень простая, но амбициозная цель — это развитие методов сильного искусственного интеллекта»

Об AIRI и разработке мультимодальных моделей

— Иван Валерьевич, AIRI — единственный институт в стране, который занимается исключительно искусственным интеллектом. Расскажите, пожалуйста, какова его цель. Как он работает?

— В России довольно много центров ИИ, но все они являются частью университетов, компаний и так далее. Мы же отдельная сущность, отдельное юрлицо. И у нас очень простая, но амбициозная цель — это развитие методов сильного искусственного интеллекта. Понятно, что до нее еще идти и идти. Илон Маск утверждает, что сильный ИИ появится в следующем году, другие говорят о сроке в 20 лет. Точных дат никто не знает.

Сейчас у нас работают порядка 200 человек — ведущие специалисты, многие из них достаточно молодые. Это математики, физики, биологи, специалисты в области машинного обучения. Все они распределены по 19 командам, каждая из которых занимается своей областью исследований.

— Какие направления вы считаете наиболее перспективными?

— Наш основной проект — над ним работает лаборатория Fusion Brain — направлен на развитие мультимодальных систем. Современные ИИ могут видеть, слышать, писать и отвечать. В этом году мы выпустим две обновленные версии модели и интегрируем в эту архитектуру медицину. Еще один проект — это воплощенный искусственный интеллект в роботе.

Но мой любимый проект — генеративное проектирование. Сейчас модели создают изображения кошечек, собачек и прочего, могут нарисовать дизайн машины, но такое авто не будет физически реализуемо. Наша задача — сгенерировать полную схему объекта и его техническую документацию. Пока это отдаленная цель, но она разбивается на более мелкие подзадачи, начиная с анализа свойств материалов, типов деталей, создания 3D-моделей. Как всегда, все упирается в данные.

Мультимодальные модели хорошо работают с картинками и текстом, потому что видят миллиарды изображений в интернете. Но техническую документацию или схемы зданий, разводки электрики и воды в интернете особо не найдешь, поэтому ее создание для ИИ — гораздо более сложная задача. Но, если наши модели смогут генерировать физически реализуемые объекты, это станет прорывом. У нас уже есть четыре потенциальных заказчика.

Иван Оселедец — доктор физико-математических наук, профессор РАН, генеральный директор Института AIRI (Artificial Intelligence Research Institute, рус. — Научно-исследовательский Институт искусственного интеллекта), профессор Сколтеха.

Лауреат премии президента РФ в области науки и инноваций для молодых ученых за создание прорывных вычислительных технологий решения многомерных задач физики, химии, биологии и анализа данных на основе тензорных разложений. Труд Оселедца также получил международное признание, его работы вошли в четвертое издание классического учебника Дж. Голуба и Ч. Ван Лоана по матричному анализу и в список наиболее цитируемых статей в предметной области.

Присоединился к AIRI в 2021 году, в 2023-м возглавил институт.

Входит в совет по науке и образованию при президенте РФ.

И очень хотим запустить проект, связанный с разработкой новых лекарств. У нас две сильные группы, но, если мы хотим не только статьи писать, требуется выстраивание очень серьезного и сложного партнерства. Правильное построение взаимодействия с фармацевтической областью — тяжелейшая задача.

«Признанным лидером в области развития ИИ являются не крупные корпорации, а компания под названием OpenAI»

«Признанным лидером в области развития ИИ являются не крупные корпорации, а компания под названием OpenAI»

«Через три года появится что-то максимально близкое к сильному искусственному интеллекту»

— Где место России в гонке искусственных интеллектов? Насколько мы отстаем?

— Признанным лидером в области развития ИИ являются не крупные корпорации, а компания под названием OpenAI. У нее 800 сотрудников. Примерно 8–9 лет назад они собрали команду из очень талантливых ребят, поставили перед собой амбициозные цели и начали двигаться в направлении развития больших моделей, сильного ИИ, привлекая крупные инвестиции. С точки зрения человеческого потенциала это не требует сотен тысяч инженеров. В этом плане у нас нет больших проблем: у нас есть сильные специалисты, многие из которых успешно работают в крупных международных компаниях.

Второй момент — это вычислительные ресурсы. Тут в силу санкционных ограничений мы действительно отстаем. Для работы со многими моделями необходимы тысячи графических карт. У лидеров в этой области, таких как Илон Маск, который собирается купить 300 тысяч графических карт, конечно, ресурсы гораздо больше. Это ограничивающий фактор.

При этом каждый раз, когда OpenAI выпускал новую модель, примерно через полгода появлялась модель такого же качества, но обученная на 10 раз меньшем количестве данных, и использующая в 10 раз меньше вычислительных ресурсов. К сожалению, пока никто в мире не сделал сразу лучше них, но само отставание сокращается довольно быстро. В этом смысле российские модели не сильно хуже тех, что есть на мировом рынке. На мой взгляд, мы находимся где-то на 5–6-м месте.

— Все идет к сильному ИИ?

— Да, сейчас все, кажется, решили, что нужно двигаться в данном направлении. Мы следим за прогрессом OpenAI, Google и других компаний, сегодня более или менее выработался способ построения таких моделей.

Мультимодальные модели — путь к сильному ИИ. Сначала они предобучаются, например, на изображениях с текстовыми описаниями. Далее оценивается их качество работы, и при необходимости корректируются параметры. Исследователи все время придумывают все более сложные задачи, условно, от школьной математики до международных олимпиад. Архитектура позволяет модели дообучаться на таких задачах и решать новые, не связанные с математикой.

Если научить модель распознавать тексты, написанные от руки, она сможет лучше решать математические примеры. Пока нет разумной теории, почему и как это происходит

Способ построения, поиск данных, их разметка и умное дообучение ведет к видимому прогрессу. И пока каких-то фундаментальных ограничений для этого процесса не видно.

— Какой должен быть результат, чтобы сказать: «Вот это точно сильный интеллект!»

— Этого пока никто не знает. Понимаю, что ответ так себе. Но что произошло, когда появился GPT? До этого ведь тоже были различные языковые модели, однако они были достаточно слабыми, человеку было неинтересно с ними взаимодействовать. В основном они использовались для каких-то узкопрофильных задач.

Я могу сказать за себя: как только ты понимаешь, что используемый инструмент для тебя полезен, интересен, ты его считаешь за субъект, задавая ему вопросы и работая с ним, — это точно уже не слабый ИИ.

Я знаю, как модели обучались, но есть свойства, которые в них изначально точно не закладывались, — они возникли самостоятельно. И ты с этой сущностью взаимодействуешь в некотором смысле действительно как с субъектом.

Более формальное определение сильного ИИ — это то, что сможет сравняться или превзойти человека в решении практически всех задачах с точки зрения качества. Пока до этого далеко, тем не менее на многих рутинных задачах уже заметно сокращается время.

— Каков прогноз AIRI по поводу появления сильного ИИ?

— Понадобится не очень много времени. Я думаю, что через два-три года появятся модели, которые точно будут сильно лучше, чем то, что есть сейчас. И мы к такому очень быстро привыкнем и не будем по поводу этого переживать.

Я бы сказал, что где-то через три года появится что-то максимально близкое к сильному искусственному интеллекту.

«Все риски, связанные с ИИ, все равно сводятся к тому, как конкретно человек, компания или государство будут этот инструмент использовать»

«Все риски, связанные с ИИ, все равно сводятся к тому, как конкретно человек, компания или государство будут этот инструмент использовать»

— На примере Сhat GPT 4о мы видим стремление компаний к созданию голосовых ИИ ассистентов, крайне похожих в эмоциональном поведении на человека. С чем оно связано? Нам не хватает общения с роботами?

— Работа западных компаний всегда обусловлена фактором экономической выгоды. Если они видят, что продукт будет востребован, они его разрабатывают. Однако для больших моделей экономическая модель пока не выстроена. Недавний пример — стартап Stability AI заработал 5 миллионов долларов, но потратил 200 миллионов. Вопрос, как на этом зарабатывать, остается открытым, так как стоимость ответа пока достаточно высокая, а люди не готовы платить значительные суммы за использование таких помощников.

Поэтому для того, чтобы поддерживать разработку, во-первых, должны быть внешние инвестиции, а во-вторых, некий фактор хайпа, чтобы в тебя еще больше вкладывали. Голосовые помощники уже давно наделены человеческими голосами, это не вызывает особого отторжения. Если они станут умнее и смогут поддерживать диалог, это будет новым опытом. Проблема возникает, когда технологии используются для обмана, как в случае с бизнесменом из Гонконга, который перевел 25 миллионов долларов мошенникам через дипфейк-звонок в Zoom. Дополнительных рисков здесь я не вижу.

— А какие риски, связанные с ИИ более страшны?

— На самом деле все риски, связанные с ИИ, все равно сводятся к тому, как конкретно человек, компания или государство будут этот инструмент использовать.

Самолеты же тоже являются крайне сложными с технической точки зрения. В начале своей истории они очень часто падали, а сегодня мы не представляем жизни без них. С ИИ все ровно то же самое. Для нас это новые возможности. Но добиться стопроцентной гарантии отсутствия рисков невозможно.

И у нас два варианта: либо идти по пути контролируемого развития, адаптировать, минимизируя риски, либо запретить целиком. Впрочем, есть еще третий вариант — вообще не контролируемый. Но, как вы понимаете, два экстремальных пути не очень нам подходят.

Научно-исследовательский Институт искусственного интеллекта AIRI — российская автономная некоммерческая организация, занимающаяся фундаментальными и прикладными исследованиями в области искусственного интеллекта. Основная цель института — создание универсальных систем искусственного интеллекта, решающих задачи реального мира

Организация появилась в 2021 году. Институт был создан для продвижения исследований и разработок в области искусственного интеллекта, а также для укрепления позиций России в глобальной технологической сфере. AIRI сотрудничает с различными организациями, включая образовательные учреждения, компании и государственные структуры, чтобы развивать инновации и внедрять передовые ИИ-решения в различных отраслях.

В AIRI работают более 200 сотрудников, 19 научных групп. За прошлый год институтом подготовлено 146 научных публикаций.

О госрегулировании, или Почему проще обрубить все по порогу

— Раз мы заговорили о регулировании: на днях в ЕС окончательно утвердили первый в мире закон об ИИ — EU AI Act. Насколько это взвешенный документ? Есть смысл нам его перенимать?

— На мой взгляд, этот закон написан как раз по одному из вышеупомянутых мною вариантов — минимизация всех рисков, чтобы абы чего не произошло. Такая регуляторика подходит к искусственному интеллекту как к обычному программному обеспечению. Однако работа алгоритмов ИИ отличается от работы обычных программ из-за их обучаемости и недетерминированных входов и выходов. Подход к ним должен быть особенным. Мне кажется, закон ЕС приведет к тому, что компании, занимающиеся искусственным интеллектом, постараются выйти за пределы европейской юрисдикции.

Попытки регулирования сейчас активизировались во всем мире. Появился совершенно «замечательный» законопроект в Калифорнии, который требует от компаний получать лицензию на обучение моделей. Я очень надеюсь, что его не примут. Однако, если это произойдет, появятся ИИ-офшоры, куда будут вывозить технологии.

Те, кто составляет эти законы об ИИ, по-моему, не очень понимают, о чем идет речь. И просто хотят себя обезопасить. Они не общество защищают, а себя — от рисков и от ответственности. Ни к чему хорошему это не приведет.

Европа в этом смысле всегда славилась консерватизмом. Мы видим, что у них нет ни собственной поисковой системы, ни социальных сетей. Да, там есть хороший французский старт Mistral, который создает модели. Но если так будет продолжаться, то многие стартапы переберутся, например, на Ближний Восток, где их активно поддержат.

— А какими в таком случае должны быть принципы регулирования, на ваш взгляд?

— Во-первых, европейские компании, занимающиеся разработкой, университеты и так далее, подписали хартию по использованию ИИ. А во-вторых, все на самом деле регулируется действующим законодательством: не используйте данные, полученные незаконным путем, или то, что вы не проверили, где цена ошибки высока. Я не вижу ни одной области, где все это не регулируется существующим законодательством и здравым смыслом.

Конечно, стопроцентной гарантии от ошибок никто дать не может, и бывают интересные случаи, которые требуют некоторой регуляторики. Если СМИ напишет что-то, нарушающее закон, оно несет за это ответственность. А если это же напишет условный чат-бот — кто будет виноват в этой ситуации? Человек, который специально вытащил из модели то, что нельзя, зная, что это противозаконно. Или модель, которая обучалась на триллионах текстов, и в условных 10 текстах что-то плохое было описано?

«Разработка качественного фильтра и цензора — сложная задача. Поэтому проще обрубить все по порогу, потенциально плохое»

«Разработка качественного фильтра и цензора — сложная задача. Поэтому проще обрубить все по порогу, потенциально плохое»

— При том что эти триллионы текстов никакой человек проверить не сможет…

— Да. Поэтому мне кажется, что если человек специально хочет вывести модель на «плохое поведение», то ответственность несет он сам. Если же сама модель начинает сразу ерунду нести, то, конечно, возникает вопрос к разработчикам, которые ее недопроверили.

Когда мы обучаем врача, мы же не можем проверить: совершит ли он в своей жизни когда-нибудь ошибку или нет. Но он сдает экзамен. Также и тут: должен быть сформирован определенный набор экзаменов и тестов, которые модель точно должна пройти. Именно так делается в московском эксперименте по медицине: прежде чем нейросеть заработает в клиниках, она должна на некоторых наборах тестовых данных показать точность не менее 90 процентов.

Мне кажется, нужно идти в направлении создания экспериментальных правовых режимов, давать право на ошибку. Основная проблема ведь в том, что сейчас ИИ — это серая зона, и никто не хочет начинать его масштабное использование, потому что «А что если?».

Например, беспилотные автомобили ездят с 2009 года, по Москве катаются не хуже, чем многие водители. Хотя бы потому что человек, сидящий за рулем 12 часов, может заснуть, а машина — нет. У нас есть уже достаточный набор статистических данных, который говорит о том, что риск от действий человека может быть даже выше, чем риск от машины. Просто никто не готов на себя взять ответственность, чтобы выпустить эти системы официально. Почему-то здесь общество выбрало путь «Лучше не стоит». Хотя до этого прекрасно садилось в самолеты, которые могли упасть с огромной вероятностью.

— Может быть, этот страх вызван тем, что у ИИ фактически нет осязаемой формы?

— У беспилотных машин-то есть форма. Кстати, это как раз то, что называется Embodied AI — следующий этап развития. Мы в AIRI тоже активно над этим работаем. Это направление про создание роботов, которые справляются с бытовыми вопросами: могут пойти и сделать вам яичницу, собрать мусор, убраться. Это сложнее, чем нарисовать видео и картинки, но это то, куда сейчас действительно направлено много внимания. И ресурсы активно инвестируются в робототехнику.

— И через сколько нам стоит ждать появления таких помощников?

— Прототипы уже есть. Так что, я думаю, очень скоро. Не знаю, когда их можно будет купить в магазине, но все к этому идет.

— Мы сейчас видим, как преступные элементы начали использовать ИИ. Дипфейки, подмена голоса и так далее стали целой проблемой. Как с этим бороться?

— В AIRI над этим работает отдельная группа — «Доверенный искусственный интеллект». В целом в мире практика такая: если возникает мошенническая система генеративного ИИ, например, генерация дипфейков для получения доступа к финансовой информации, создается другая модель, которая детектирует подобные атаки.

Например, при распознавании лиц в банках каждый раз, помимо непосредственно систем распознавания, включаются системы детекции фейков, обученные на больших дата-сетах атак.

Преступники придумывают свои приколы: маски подсовывают в камеру, засвечивают лица, очки какие-то специальные надевают. С другой же стороны работают (и постоянно дообучаются) нейросети, распознающие всех этих товарищей.

Даже в случае с большими языковыми моделями существуют так называемые Red Team, которые следят за тем, чтобы не дай бог модель как-то неправильно не ответила и не нарушила законодательство или не навредила кому-то. Есть нейросети-«цензоры».

Если условный чат-бот спросить о чем-то не том, он вам цветочки нарисует. Но есть другая интересная проблема: как только вы вводите цензурирование, качество модели ухудшается. Например, модель попросили нарисовать двух женщин-ученых с пробирками, а модель выдала цветочки.

— Почему?

— Две женщины, а вдруг это опасная тема. То есть поставили грубый фильтр. Модель отфильтровала, конечно, но не то.

— И где граница такой цензуры?

— Разработчикам проще и дешевле поставить фильтры и ждать вопросы про то, по какому рецепту сегодня готовить, а не, условно, про существующие в РФ политические партии. Но и тут возникают недовольные: «А что это твоя модель не отвечает на вопросы про политические партии? Ты, наверное, иноагент».

Это вечная проблема. Разработка качественного фильтра и цензора — сложная задача. Поэтому проще обрубить все по порогу, потенциально плохое. Что-то и совсем безобидное вылетит? Ну, зато мы никогда не получим ненужный вопрос. Другое дело, что это все обходится. Невозможно на 100% защититься, если модель в обучающей выборке хоть пару раз видела какую-то ерунду.

— Как вообще наши правоохранительные органы работают со всеми этими моделями?

— А они пока не до конца понимают, как работать, потому что нет нормативной правовой базы. Как к моделям подходить? Как к средствам массовой информации? Они же что-то пишут. Или как к людям? Человек тебя спросил, а ты начала рассказывать, а ведь знала же, что нельзя.

И вот здесь требуется нормальная регуляторика. Например, дается время на то, чтобы какой-то лаг исправить, убрать сообщение из генерации. Сейчас даже целые отдельные направления науки возникли: есть machine learning, машинное обучение, а есть machine unlearning — как заставить модель что-то забыть. Она что-то увидела, а ей говорят: «Так, ты не видела этого никогда, убери».

— А модель отвечает: «Нет, видела!»

— Да, это вообще не так просто. У нее где-то в бесконечном количестве параметров записалась информация про какого-то конкретного человека или про какой-то конкретный факт. И вдруг ее надо удалить. Это отдельная интересная задача.

«В университетах из 100 студентов по статистике остается 10 аспирантов, научным лидером станет один из ста»

«В университетах из 100 студентов по статистике остается 10 аспирантов, научным лидером станет один из ста»

«В России одна из главных проблем — слабая горизонтальная мобильность»

— Какова сегодня ситуации с кадрами в области ИИ? Где брать специалистов и лидеров, которые будут двигать это направление?

— Лидеры выращиваются. Еще лет 10 назад в стране практически не было научных групп, занимающихся серьезными исследования в области ИИ. Сейчас ситуация постепенно меняется, начинают публиковаться ученые, кто-то приходит из смежных областей. Ведь у нас даже специальности по компьютерным наукам после Союза не было — только вычислительная и чистая математика.

В университетах из 100 студентов по статистике остаются 10 аспирантов, научным лидером станет один из 100. С таким фактором конверсии нужно на входе большое количество студентов. А еще у этого процесса есть срок: базовый курс, два года магистратуры, три года аспирантуры. Так что за пять лет можно из 100 человек вырастить одного научного лидера.

Сейчас мы максимально накопили тех, кто мог бы этим заниматься, наши ученики сами стали руководители научных групп, кратно увеличивается и количество студентов. Соответственно, через 5 лет можно ожидать кратного увеличения числа научных лидеров, и у нас пойдет нормальный экспоненциальный рост. Он уже начался, но для того, чтобы коэффициент этой геометрической прогрессии увеличивать, нужно поддерживать научные группы и увеличивать воронку кадров.

— Власти озвучивают потребность в ИИ-специалистах на уровне 15 тысяч выпускников ежегодно. Этого достаточно?

— Я бы сказал, что маловато. Но порядок цифр правильный. И на самом деле точки роста у нас формируются в совершенно неожиданных местах, не только в Москве. Сейчас у нас есть шесть центров по ИИ первой волны — Сколтех, Университет Иннополис, Университет ИТМО, НИУ ВШЭ, МФТИ и ИСП РАН имени Иванниĸова. Есть центры второй волны, более прикладные — в Самаре, Нижнем Новгороде, Екатеринбурге, Новосибирске.… Возможно, на нулевом этапе там нет таких красивых публикаций, зато очень много талантливых и умных людей. И везде нужны такие точки роста.

Например, в Якутске некоторое время назад выиграл мегагрант профессор из Техаса, этнический азербайджанец, который давно уехал в Америку. Сейчас в Якутии у него защитилось 12 человек, молодые ребята, но уже пишут статьи. В Донецке огромное количество толковых ребят по робототехнике.

К нам приходят ребята из совершенно разных регионов. Может быть, и не нужно, чтобы в каждом субъекте было по тысяче таких человек. Но если хотя бы из каждого будет два-три толковых студента — отлично. Мы можем, например, в том же Сколтехе их дообучить, а потом, если будут условия, они могут вернуться домой и вокруг себя что-то построить.

Школьники сейчас бывают тоже очень интересные, из разных областей. Со всеми надо работать.

— Но, наверное, талантливых детей не всегда замечают?

— Талантливых ребят очень много, но они могут теряться на каком-то этапе, например, если нет сильных преподавателей. Над этим, конечно, тоже нужно работать.

Александр Гасников, который поехал в Иннополис, очевидно, выстраивает мощный образовательный центр.

У нас в Сколтехе трудился один бельгиец, а сейчас пошел профессором в Иннополис. Поэтому, мне кажется, нам надо максимально децентрализовываться и партнериться с разными вузами.

В России одна из главных проблем — слабая горизонтальная мобильность. Люди мало общаются друг с другом. В Европе специалист может сесть на поезд, поехать в другой город, поработать со сторонней группой два-три месяца, сделать новые интересные вещи. Под все это выделяется финансирование. У нас же это пока не принято. Я очень давно пытался такие программы запускать, что-то даже получается, но вечно возникают какие-то сложности. Понятно, что страна большая, но самолеты же летают.

— Кафедры в вузах от ведущих компаний — это рабочая история?

— Главное, чтобы кафедра от компании не играла только роль пылесоса. Например, тот же Яндекс поддерживает научную группу в ВШЭ, но не заставляет людей работать потом на себя. В Китае бизнес активно финансирует лаборатории, потому что они понимают: лаборатория потом будет готовить кадры. А если вы будете забирать сырых специалистов на первом-втором курсе, все равно придется потратить кучу времени и ресурсов на их переподготовку.

Кстати, это одна из основных бизнес-проблем: нет доверия. Мысль, что в университете ничему не научат. Поэтому компании действуют так: сейчас наймем студентов, сами обучим — а в итоге ребята и не учатся, и не работают нормально. Университеты без хороших студентов загибаются, а компании получают людей без законченного образования. Вся система становится неустойчивой. Вот эта философия, что надо схватить студента побыстрее, местами становится чуть ли не национальной идеей. С этим надо бороться.

Нужно поднимать престиж занятий наукой. Прийти к пониманию, что научная степень — это существенный вес и существенное достижение. На Западе, например, этап, когда можно было работать в компании без степени, уже почти прошел. Кроме того, недавно в отчете Стэнфорда привели интересные данные о том, что люди со степенью зарабатывают в среднем больше. Это стало выгодным, и поэтому ценится, в том числе и в индустрии.

— Сейчас активно обсуждается необходимость внедрения программ по ИИ даже в школьное образование. Однако ректор Иннополиса Александр Гасников уверен, что начинать следует с восстановления сильной математической подготовки в большинстве образовательных учреждений. Как вы считаете, когда надо начинать учить работе с ИИ?

— Этот вопрос очень многогранный. Прежде всего, это не должно делаться в ущерб базовым предметам. Второе — есть риск, что при текущем уровне преподавания в некоторых школах ученики будут лучше разбираться в теме, чем учителя. Хотя бы потому, что они уже начинают пользоваться генеративными моделями.

Интеграция элементов искусственного интеллекта в информатику, например, безусловно, необходима. Нет смысла объяснять устаревающие вещи, учить печатать на клавиатуре. Нужно следить за развитием и интегрировать новые знания. Но вводить ИИ как обязательный предмет нет смысла.

На мой взгляд, это могло бы быть в рамках спецкурсов, кружков или в селективных школах. Чтобы, например, приходили выпускники, аспиранты, читали лекции.

Сейчас уже проводят международные олимпиады школьников по ИИ. Чем это хуже физики? Да ничем. Но опять же, нужно, чтобы базовые предметы были на хорошем уровне. А все остальные вещи — вторичны.

— А базовые — это какие? Математика?

— Конечно, математику, физику, русский язык обязательно нужно учить на хорошем уровне. Биология, химия — тоже важные предметы.

На самом деле это интересный вопрос, чему нужно учить людей, которые хотят стать специалистами в области искусственного интеллекта. Условно говоря, нужно ли их учить физике, если они хотят программы писать? Однако мы пришли к выводу, что они являются элементом базовой культуры, что должны быть предметы с непреложной истиной. Они помогают выстраивать логические цепочки в голове. А если этого нет, то тогда вся картина мира становится немного размазанной. И это мешает созданию чего-то своего.

«В 2016 году Джеффри Хитон, один из отцов-основателей deep learning, глубокого машинного обучения, сказал, что больше не надо учиться на врача-рентгенолога. Но с тех пор врачей-рентгенологов стало еще больше»

«В 2016 году Джеффри Хитон, один из отцов-основателей deep learning, глубокого машинного обучения, сказал, что больше не надо учиться на врача-рентгенолога. Но с тех пор врачей-рентгенологов стало еще больше»

«Никто не понимает, почему модель так работает»

— Один из самых популярных страхов, что ИИ придет и очистит от людей рынок труда. Насколько велики риски для специалистов, не связанных с искусственным интеллектом?

— Мне кажется, риски не очень высоки. Такие системы могут действительно заменить рутинные действия, сократить количество подобной работы. Возьмем бухгалтерию: до системы 1С все считали вручную 3–4 бухгалтера. Сейчас достаточно 1–2 специалистов и программы, оставшиеся или ушедшие бухгалтера все равно нашли работу, и никакой трагедии не случилось.

На самом деле нужно учиться работать с новыми инструментами, иначе некий риск, что вас заменит специалист, владеющий технологиями ИИ, действительно может возникнуть. И это логично: такой инструмент повышает производительность труда.

Уже несколько лет существуют системы, которые рисуют картины, а количество художников и дизайнеров не уменьшилось. В 2016 году Джеффри Хитон, одним из отцов-основателей deep learning, глубокого машинного обучения, сказал, что больше не надо учиться на врача-рентгенолога. Но с тех пор врачей-рентгенологов стало еще больше, потому что человек — насколько сложная биологическая система, что мы до сих пор до конца не понимаем, как он устроен. То есть мы способны по понятному снимку определить патологию. Но выяснить, а как это лечить, а с чем это связано в истории болезни — сложнее. То есть ИИ — это такой мультипликатор возможностей человека, но не его замена.

— Мы вообще понимаем, как генеративная модель работает? Почему она иногда выдает неожиданные, не те результаты?

— Никто не понимает, почему это так работает. Более того, существующая математическая теория не может объяснить эффективность моделей даже при небольшом количестве данных на обучении. Это одна из основных нерешенных проблем. Собраны целые группы математиков, которые пытаются составить какую-то стройную теорию.

На данный момент модели — это создания инженеров, которые накрутили друг на друга алгоритмы, обучили на данных. Но никто не может дать ответ, а сколько модели вообще нужно данных, чтобы она выучилась с нужной гарантией. Пока это все описательная наука. Мы обучили эту штуку, но как она работает, какие у нее свойства, можно ли проверить ее внутренние характеристики и как они связаны с другими свойствами — тут поле для исследований. И это, на мой взгляд, сейчас одно из самых важных направлений.

У нас есть определенные результаты. Например, мы исследуем психологический профиль этих моделей, связь с некоторыми внутренними значениями нейронов. Получаются довольно интересные корреляции.

— А сам ИИ может нас обманывать? Есть же миф, что генеративные модели нам врут, причем намеренно.

— Открытый вопрос, способна она ли на создание чего-то принципиально нового, лежащего вне того, что мы сами видели. Пока у меня нет ответа. Скорее всего, пока она синтезирует, адаптирует то, что есть. Работает на уровне хорошего ударника. Не гениально, но полезно. И даже на этом уровне многие системы, которые сейчас пишут музыку, на мой взгляд, справляются лучше, чем часть отечественной эстрады.

Комментарии 2

Редакция оставляет за собой право отказать в публикации вашего комментария.

Правила модерирования.